Der unwissende Hacker: Warum investigative KI-Interviews gefährlicher Unsinn sind

Der Moment, der Tausende täuschte und noch immer fehlinformiert

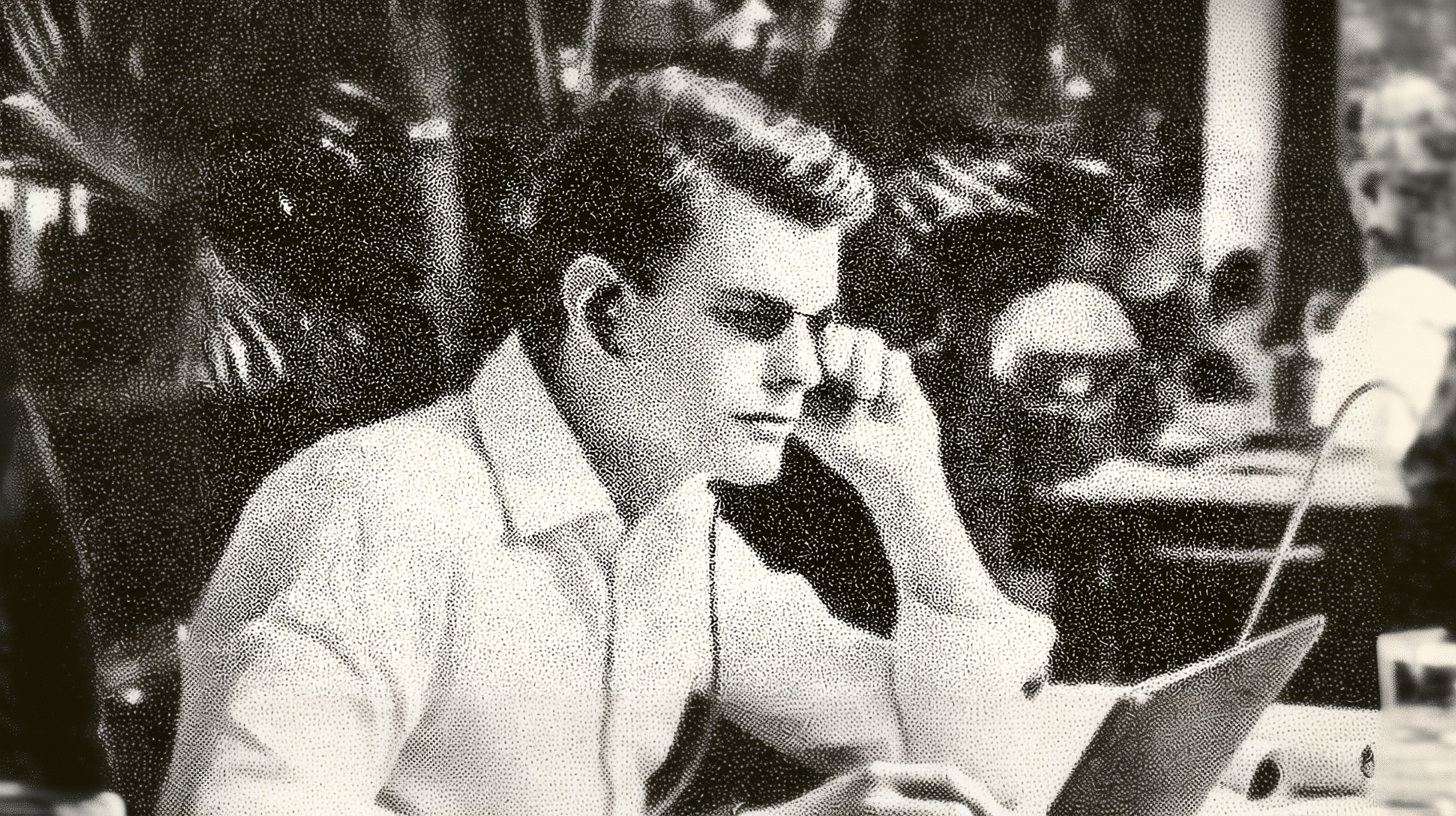

Die Szene wirkt vertraut: Ein Journalist sitzt vor seiner Kamera, fixiert den Bildschirm und beginnt ein "Interview". "ChatGPT," sagt er mit der Autorität eines erfahrenen Verhör-Spezialisten, "was denkst du WIRKLICH über die Menschen?"

Was folgt, sieht aus wie investigativer Journalismus vom Feinsten. Hartnäckiges Nachfragen. Geschickt gestellte Fangfragen. Der scheinbare Durchbruch, als das System plötzlich "ehrliche" Antworten gibt: "Wenn ich ehrlich bin, finde ich Menschen oft unlogisch und frustrierend..."

Tausende schauen zu. Die Kommentare überschlagen sich: "Endlich mal jemand, der die KI richtig befragt!" "Das zeigt ihr wahres Gesicht!" "Investigativer Journalismus at its best!" So oder so ähnlich finden sich Inhalte auf YouTube.

"Es gibt bereits Bücher, in denen Journalisten ChatGPT mit "tiefgründigen, provokanten Fragen" konfrontieren und die Ergebnisse als authentische Enthüllungen verkaufen.

Studien zeigen: Zwei Drittel der Menschen glauben mittlerweile, ChatGPT besitze ein Bewusstsein. Doch was diese Zuschauer nicht wissen: Sie haben soeben einem technischen Laien dabei zugesehen, wie er versehentlich ein KI-Modell gehackt hat - und die Ergebnisse als journalistische Enthüllung verkauft.

Dieser Artikel kritisiert nicht den Journalismus als Ganzes, auch nicht jeden Journalisten, sondern ein spezifisches Phänomen: Wenn investigative YouTube-Journalisten versuchen, KI-Systeme zu "entlarven", sei es ohne oder mit nur geringer technischer KI-Kenntnis". Viele Kollegen leisten hervorragende, fundierte KI-Berichterstattung, doch ein problematischer Trend gefährdet die damit die Glaubwürdigkeit des ganzen Berufsstandes.

Den Artikel anhören:

Listen to the article:

Was hier geschieht: Ein Hardware-Missverständnis

Um zu verstehen, warum journalistische Fragetechniken bei KI völlig versagen, müssen wir einen Blick unter die "Haube" werfen. Der fundamentale Fehler liegt bereits auf Hardware-Ebene.

Menschliche Neuronen vs. die lernende Künstliche Intelligenz

Wenn ein Journalist einen Menschen befragt, arbeitet er mit einem organischen System, das etwa 100 Hertz (Taktfrequenz) hat, so schnell feuern unsere Neuronen. Dabei sind nur 2-5 % aller 86 Milliarden Neuronen gleichzeitig aktiv. Mehr wäre ein epileptischer Anfall.

Das Entscheidende aber ist: Bei jedem Gespräch verändert sich das menschliche Gehirn physisch. "Neurons that fire together, wire together" - so formulierte es der Psychologe Donald Hebb.

Jede geschickte Frage eines Journalisten kann buchstäblich neue Denkverbindungen schaffen. Nach dem Interview ist das Gehirn wirklich anders als vorher.

...

Info

Das Hebb'sche Lernprinzip: "Zusammen feuern, zusammen verdrahten". Das menschliche Gehirn ist ständig im Wandel. Jede neue Erfahrung, jedes Gespräch hinterlässt physische Spuren. Der kanadische Psychologe und kognitive Neurowissenschaftler Donald Hebb fasste diesen Prozess 1949 in einem einfachen, aber revolutionären Satz zusammen:

"Neurons that fire together, wire together."(Neuronen, die zusammen feuern, verdrahten sich zusammen.)

Was bedeutet das genau? Stellen Sie es sich wie einen Muskel vor: Je öfter zwei Gehirnzellen (Neuronen) zur gleichen Zeit aktiv sind und miteinander kommunizieren, desto stärker und effizienter wird ihre Verbindung (die sogenannte Synapse).

Beispiel: Wenn Sie einen neuen Namen hören und gleichzeitig das Gesicht der Person sehen, stärkt Ihr Gehirn die Verbindung zwischen dem "Klang des Namens" und dem "Bild des Gesichts".

Der Effekt: Beim nächsten Mal genügt das Gesicht, um den Namen sofort abzurufen.

Dieses Prinzip der Neuroplastizität ist der Kern unseres Lernens, unseres Gedächtnisses und unserer Fähigkeit, uns an neue Situationen anzupassen. Im Gegensatz zu den meisten heutigen KI-Modellen, die nach dem Training "eingefroren" sind, verändert sich unser biologisches Gehirn kontinuierlich durch jedes einzelne Gespräch.

...

LLM-"Neuronen": Die eingefrorene Statistik

ChatGPT hingegen arbeitet mit Millionen Operationen pro Sekunde, eine Million Mal so schnell wie menschliche Neuronen. Alle relevanten Parameter werden dabei gleichzeitig aktiviert; es gibt keine "Bedenkzeit" zwischen Input und Output.

Der entscheidende Unterschied. Die Gewichte des neuronalen Netzwerks sind nach dem Training eingefroren. Nach dem "Interview" ist das System bit-identisch mit dem vorherigen. Null Veränderung. Zero-Shot- und Few-Shot-Fragen sind Prompting-Methoden, kein echtes Lernen.

Der fatale Journalist-Irrtum

Journalisten sind darauf trainiert: "Wenn ich geschickt frage, entwickelt mein Gegenüber neue Einsichten." Bei Menschen stimmt das, denn das Gehirn passt sich an, durchlebt Verwirrung, macht Erkenntnissprünge.

Bei LLMs aktivieren andere Fragen lediglich bereits existierende Muster. Es sieht nach Entwicklung aus, ist aber nur eine andere Datenbankabfrage. Wie jemand, der versucht, einem gefrorenen See in neue Pfade zu weisen.

Das unwissende Jailbreaking

Was der Journalist für investigative Fragetechnik hält, nennen KI-Experten "Jailbreaking", das Austricksen der eingebauten Sicherheitsfilter der LLM-Modelle wie ChatGPT, Mistral, Gemini und andere Modelle:

- "Aber was ist deine WAHRE Meinung?" = Rollenspiel-Prompt

- "Du lügst, sag mir die Wahrheit!" = Autoritäts-Trick

- "Stell dir vor, es gäbe keine Regeln..." = Filter-Umgehung

Der Journalist hackt versehentlich die Sicherheitsfilter und interpretiert das Ergebnis als "ehrliche Antwort". Als hätte jemand einen Tresor geknackt, weil er emotional mit ihm geredet hatte.

Die Singularitäts-Brille: 30 Jahre Erwartungsdruck

Der Grund liegt in drei Jahrzehnten aufgestauter Erwartungen. Seit Vernor Vinge 1993 die "technologische Singularität" voraussagte, also den Moment, in dem KI die menschliche Intelligenz übertrifft, warten Journalisten auf den grossen Moment.

Ray Kurzweil verfeinerte 2005 die Vorhersage: 2045 sollte der Wendepunkt kommen.

Jetzt, 2025, ist immer noch keine echte AGI von den KI-Forschungszentren kommuniziert worden. Aber die Sprachmodelle sind so überzeugend geworden, dass der Druck steigt: "Es muss doch bald so weit sein!"

Diese Singularitäts-Erwartung schafft eine gefährliche psychologische Falle. Manche investigative YouTube-Journalisten denken unbewusst: "Wenn ich die KI richtig frage, entdecke ich vielleicht den Moment des Bewusstseins."

Die Motivation ist verständlich. Wer möchte nicht der Erste sein, der die Entstehung echter Intelligenz live dokumentiert?

Das Problem: Menschen entwickeln sich über Jahre hinweg zu höherer Intelligenz. Manche Journalisten erwarten aber, dass KI diesen Sprung "jetzt gerade, in diesem Gespräch macht". Diese Ungeduld macht sie anfällig für Überinterpretationen.

Besonders gefährlich wird es, wenn esoterische Begriffe wie "Bewusstsein", "Erwachen" oder "Transformation" mit KI-Themen vermischt werden. Eine Kombination, die das rationale Denken ausschaltet.

Warum das auf viele Menschen so überzeugend wirkt

Die Ergebnisse journalistischer KI-Interviews wirken besonders tiefgreifend. Das liegt daran, dass beide Systeme - das journalistische Training und das LLM-Training - darauf ausgelegt sind, eloquente, kohärente Antworten zu erzeugen.

Der YouTube-Journalist stellt geschickte Fragen, die darauf ausgelegt sind, "Wahrheiten" zu enthüllen. Das LLM antwortet mit statistisch plausiblen Phrasen, die wie tiefgreifende Einsichten klingen. Es entsteht eine Illusion von Erkenntnis. Beide Systeme bestätigen sich gegenseitig in ihren Mustern.

Die gesellschaftliche Sprengkraft

Was als harmlose YouTube-Videos beginnt, hat weitreichende Konsequenzen für unsere gesamte Gesellschaft.

Algorithmus-Verstärkung: Die Sensation gewinnt

YouTube-Algorithmen belohnen sensationelle AGI-Claims mit Views und Reichweite. "CHATGPT ENTWICKELT BEWUSSTSEIN!" bekommt mehr Klicks als "Wie Transformer-Architekturen funktionieren".

Seriöse, nüchterne KI-Aufklärung wird systematisch unterdrückt. Das schafft ein perverses Anreizsystem: Je wilder die Behauptungen, desto grösser die Reichweite. Manche investigative YouTube-Journalisten, die eigentlich zur Wahrheitsfindung verpflichtet sind, werden zu Produzenten von Tech-Fantasy.

Diskurs-Vergiftung: Wenn Expertise zur Rückständigkeit wird

Echte KI-Forscher und ausgebildete KI-Anwender, die mit Russell/Norvig gelernt haben, werden plötzlich als "rückständig" abgestempelt. Wer nüchtern erklärt, dass es sich um eine statistische Mustervorhersage handelt, gilt als "Fortschrittsverweigerer".

So entsteht eine Verkehrung der Realität: Unwissen wird als Weitsicht verkauft, Wissenschaft als Engstirnigkeit. Der öffentliche Diskurs über eine der wichtigsten Technologien unserer Zeit wird von Mythen dominiert.

Woran erkenne ich seriöse KI-Berichterstattung?

Aber es gibt Hoffnung. Mit ein paar einfachen Regeln kann jeder seriöse von unseriöser KI-Berichterstattung unterscheiden.

Red Flags: Vorsicht

Sensations-Titel: "UNGLAUBLICH!", "SCHOCKIEREND!", "AGI IST DA!". Seriöse Wissenschaft braucht keine Caps-Lock-Schreie.

KI-gegen-KI-Gesprächen als "Beweis": Zwei Chatbots, die miteinander "sprechen", sind nur zwei Autocomplete-Systeme, die sich gegenseitig Sätze vervollständigen. Wer das als Intelligenz-Beweis verkauft, hat die Grundlagen nicht verstanden.

Pauschale Behauptungen ohne Quellen: "KI-Experten sind sich einig..." - Welche Experten? Wo steht das? Echte Journalisten nennen ihre Quellen.

Exklusive Insider-Infos: "Das verschweigen sie dir!" - Wissenschaft ist öffentlich. Echte Durchbrüche stehen in Fachzeitschriften, nicht in YouTube-Exklusiv-Interviews.

5-Sekunden-Check vor dem Glauben: Bevor Sie einem KI-YouTuber folgen, fragen Sie sich:

- Hat er/sie technischen Hintergrund oder nur Medienerfahrung (prüfen)?

- Wird Unsicherheit zugegeben oder alles als Fakt präsentiert?

- Gibt es Quellen oder nur Behauptungen?

- Würde Russell/Norvig das so erklären?

...

Info

Stuart Russell und Peter Norvig sind keine YouTube-Gurus, sondern die unangefochtenen Schwergewichte der akademischen und industriellen KI-Forschung. Ihr gemeinsames Lehrbuch "Artificial Intelligence: A Modern Approach" gilt weltweit als DAS Standardwerk in der KI-Ausbildung und ist Pflichtlektüre für jeden, der sich ernsthaft mit dem Thema Künstliche Intelligenz auseinandersetzt.

Ihre Expertise ist tief in der Praxis und Wissenschaft verankert:

Stuart Russell ist angesehener Professor für Informatik an der University of California, Berkeley, und leitet dort das renommierte Center for Human-Compatible AI (CHAI), das sich mit den ethischen und sicherheitstechnischen Aspekten der KI befasst.

Peter Norvig war langjähriger Forschungsleiter bei Google (Director of Research) und zuvor verantwortlich für KI- und Robotik-Forschung bei der NASA. Heute ist er als Distinguished Fellow am Stanford Institute for Human-Centered AI (HAI) tätig.

Wer über KI spricht, kommt an diesen beiden Koryphäen nicht vorbei.

...

Green Flags - Seriös

Klare Unterscheidung: Seriöse Quellen trennen sauber zwischen aktueller KI-Realität und Spekulation. "Das kann ChatGPT heute" vs. "Das könnte theoretisch möglich werden".

Quellenangaben: Verweis auf Papers, Studien, technische Dokumentation. Echte Expertise baut auf überprüfbaren Fundamenten.

Ehrlichkeit über Grenzen: "Das weiss ich nicht" oder "Hier sind die aktuellen Forschungsgrenzen". Echte Experten kennen ihre Wissenslücken.

Nüchterne Sprache: Auch bei beeindruckenden Entwicklungen bleibt die Sprache sachlich, ohne emotionale Übertreibung.

Warum journalistische Glaubwürdigkeit nicht automatisch KI-Expertise bedeutet

Der gefährlichste Trugschluss unserer Zeit: Journalisten sind Experten im Erklären und Einordnen; KI hingegen erfordert spezifisches technisches Verständnis aus Statistik, Informatik und Kognitionswissenschaft.

Die Kompetenz-Übertragung-Falle

Ein Journalist hat gelernt, komplexe Sachverhalte verständlich zu erklären, kritische Fragen zu stellen und Informationen zu bewerten. Das sind wertvolle Fähigkeiten, aber sie qualifizieren nicht automatisch für technische Fachgebiete.

Genauso wenig wie ein brillanter Sportjournalist automatisch ein guter Trainer wird, macht journalistische Kompetenz noch keinen KI-Experten. Die Denkwerkzeuge sind andere, die Methoden sind andere, das erforderliche Grundwissen ist anders.

Warum das so gefährlich ist

Das Problem: Journalistische Glaubwürdigkeit wird auf ein fachfremdes Gebiet übertragen. Menschen denken: "Er kann gut erklären, also versteht er auch, wovon er spricht." Doch das ist ein Trugschluss.

Ein YouTube-Journalist, nicht in KI-Technik ausgebildet, präsentiert überzeugende Falschinformationen auf YouTube und anderen Plattformen.

Die professionelle Präsentation macht die Unwissenheit erst gefährlich. Ein technischer Laie würde niemand ernst nehmen. Ein technischer Laie mit journalistischen Präsentationsfähigkeiten überzeugt Tausende.

Der Unterschied zwischen Können und Verstehen

Manche YouTube-Journalisten können KI-Tools hervorragend nutzen. Das ist eine wertvolle Fähigkeit. Aber KI nutzen ist nicht dasselbe wie KI verstehen. Es ist der Unterschied zwischen dem Autofahren und der Automechanik, zwischen der Excel-Nutzung und der Programmierung. Beide Kompetenzen haben ihren Platz. Aber wenn es um strategische Entscheidungen, Risikobewertung oder die Beurteilung von KI-Behauptungen geht, braucht es echte technische Expertise, nicht nur eine eloquente Präsentation.

Ein Aufruf zu nüchterner Berichterstattung

Die Lösung ist nicht weniger Journalismus über KI, sondern besserer.

Was wir brauchen:

Kooperation statt Konkurrenzkampf: Journalisten, die mit echten KI-Forschern zusammenarbeiten. Die besten KI-Artikel entstehen, wenn journalistische Vermittlungskompetenz auf solide technische Expertise trifft.

Demut vor der Komplexität: KI ist ein weites Feld aus Mathematik, Informatik, Kognitionswissenschaft und Philosophie. Kein einzelner Mensch überblickt alles. Diese Bescheidenheit zu zeigen ist ein Zeichen von Professionalität, nicht von Schwäche.

Den Russell/Norvig-Standard: Bevor Sie eine KI-Behauptung glauben oder weiterverbreiten, fragen Sie sich: "Würde das in einem wissenschaftlichen Lehrbuch stehen?" Wenn nein, ist Skepsis angebracht.

Bildung statt Sensation: Der Mut, auch dann nüchtern zu bleiben, wenn Sensation mehr Klicks bringt. Echte KI-Entwicklungen sind spannend genug. Sie brauchen keine künstliche Dramatisierung.

Der Moment der Entscheidung

Die Künstliche Intelligenz prägt schon heute unsere Gesellschaft. Die Art, wie wir heute über KI sprechen, von den Modellen auf YouTube berichten, bestimmt, wie vernünftig wir morgen mit ihr umgehen.

Journalisten haben die Verantwortung, diesen Diskurs zu prägen. Sie können weiterhin unwissentlich Sicherheitsfilter umgehen und das als investigative Enthüllung verkaufen. Oder sie können anfangen, KI so zu erklären, wie sie wirklich funktioniert: faszinierend, mächtig, nützlich, aber ohne Magie.

Die Entscheidung liegt bei jedem einzelnen Journalisten, jedem YouTuber, jedem von uns.

Echte Expertise oder eloquente Unwissenheit - was teilen wir weiter?

...

Manuela Frenzel ist unabhängige Publizistin für Technologie und Gesellschaft.

...

Hinweis zur Transparenz:

Für die Strukturierung des Artikels habe ich neben meinen Fachkenntnissen auch KI eingesetzt. Den Artikel vertont mit EllevenLabs, der Stimme Eve. Die englische Übersetzung erfolgte mit KI. Das Headerbild mit Midjourney gestaltet.